Collaboration

音の力で世界を拡張する、

革新的なリアルタイム・インタラクションの創出

2020年6月19日

-

① 山本 一幸

ソニー株式会社

R&Dセンター

Tokyo Laboratory 08 -

② 木下 隆

ソニー株式会社

R&Dセンター

Tokyo Laboratory 08 -

③ 伊藤 博史

ソニーホームエンタテインメント

&サウンドプロダクツ株式会社

V&S事業本部

Sound Wearable準備室 -

④ 川上 高

ソニーホームエンタテインメント

&サウンドプロダクツ株式会社

HESソフトウェアセンター

V&Sソフトウェア技術部門 5部

-

⑤ 近藤 博仁

ソニーホームエンタテインメント

&サウンドプロダクツ株式会社

V&S事業本部

Sound Wearable準備室 -

⑥ 八木 泉

ソニーホームエンタテインメント

&サウンドプロダクツ株式会社

V&S事業本部

Sound Wearable準備室 -

⑦ 布沢 努

株式会社ソニー・インタラクティブ

エンタテインメント

ワールドワイド・スタジオ

JAPANスタジオ

クリエイティブサービス部 -

⑧ 井手口 悦久

株式会社ソニー・ミュージック

ソリューションズ

マーケティング戦略本部

マーケティング戦略オフィス

現在のスマートフォンに加えて、ヒアラブル端末やメガネ型といった、聴覚や視覚に直接情報を送る端末が登場し、常時ネットワークにつながり続ける世界が現実味を帯びてきている。社会インフラの変化と共に、人と機器、情報の関係が変質し、これまでのインタラクションの在り方も大きな変革期を迎えようとしている。これらのヒアラブル端末の未来を拓くために立ち上げられた「Sound AR™プロジェクト」。そのコア技術には革新的なリアルタイム・インタラクションの創出が欠かせなかった。このプロジェクトに携わった技術者たちに、プロジェクトの発端やSound AR技術、さらには体験コンテンツや音作りへのこだわりについて話を訊いた。

インタラクションの変革期

──今、インタラクションはどのように変化し、今後どう進化を遂げるのでしょうか?

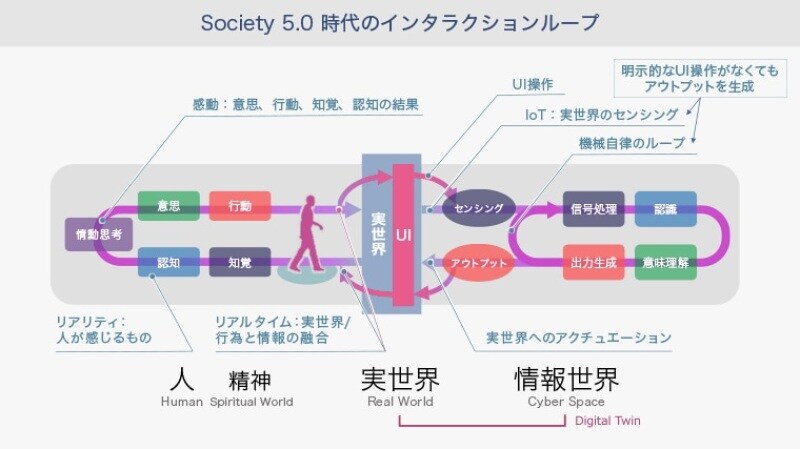

山本:これまでのインタラクションは、タッチパネルやボタンを押すことでアプリケーションが動き、情報がディスプレイやスピーカーへと返ってくるというものでした。ところが、社会インフラやインターフェイスが変わり始めたことで、機器も変化の狭間にあり、それに伴いインタラクションも大きく変わろうとしています。タッチ操作ではなく、AR(拡張現実)やVR(仮想現実)のようにジェスチャーなど身体性のある入力であったり、例えばIoTデバイスでセンシングをしたり、AI(人工知能)が自発的に考えて人にアウトプットするような明確な入力のないものなど、今までの「入力・出力」とは全く違うものが生まれ始めています。ボタンを押すと反応が返ってくるという大昔から続いてきた世界が完全に変わり、「人」対「機械世界」「情報世界全体」という、とても広い組み合わせになっていく。巨大なゲームチェンジが起こるだろうと私たちは考えています。

川上:私はこれまで対話機能を持つスマートプロダクトの製品開発に携わってきましたが、その中で考え続けたことのひとつが、果たして対話が必要なのだろうか?ということです。一例を挙げれば、海外から日本に来た方が驚くことのひとつに、「あれ」と言ったら「あれ」が出てくる、いわば「察するコミュニケーション」のようなものがあります。そのほうがコミュニケーションコストは低く、ある種のユーザーにとっては非常に快適なわけです。

山本:スマートスピーカーに話しかけて反応が返ってくるのは、ボタンを押して反応が返ってくるインタラクションと基本的には変わりません。100年前のUI(ユーザーインターフェイス)と同じです。しかしこの先、どれだけデバイス側でユーザーの状況や意図を理解できるかによって、会話の質は変わると思います。ユーザーが質問して答えが返ってくるという会話はこれからも存続すると思いますが、今のままだとなかなか使えないシチュエーションも多い。例えば、屋外でAIアシスタントを頻繁に使えるかというと、人目も気になり使いづらいというデータもあります。会話でコミュニケーションを行う段階から一歩進化させないと、AIを活用できるシーンが限定的になってしまうかもしれません。

伊藤:私たちの中でもよく出てくる議論で、「AIアシスタントに任せればいい」という整理だけで思考を止めてしまう人もいます。もちろん、AIアシスタントに任せる部分はあるとは思いますが、私たちソニーはデバイス、センシング技術や空間音響技術などに多くの強みを持っていますので、うまくAIと連携し、新しい体験を共創するやり方があるのではないかと考えています。例えば、スマートフォンやヘッドフォンのセンサーを生かして、ユーザーの現在の状況をデバイス側がもっと理解できるようになれば、AIに尋ねるまでもなく必要な情報を自動で教えてくれる。必要な情報が必要な時に自然に入ってくるという、人にとってより心地よい体験にたどり着ける可能性があるのではないかと思っています。

山本:対話というのはインタラクションの一片でしかなく、デバイスに向かって会話している状態というのも一時的なもので、もっと自然な状態があるべきだと思いますね。

偏ってしまった情報取得のバランスを整える

──情報取得のもっと自然な状態とはどのようなものでしょうか?

川上:街でスマートフォンを見ながら歩いている人を見ると、「情報世界」が「実世界」に浸食しているという印象を受けます。次世代通信5Gでは10Gbpsを超えるようなデータが扱えると言われていますが、受け手側は10Gbpsも処理できません。つまり、実世界の人は情報量に圧倒されているのです。処理できないほどの圧倒的な量の情報が届いてしまっているから、道を歩いていても常にスマートフォンを見ないと追いつかないのです。この社会的な課題に対するソリューションとして、ユーザーの状況を理解し、サウンドで情報を得られる新しいAR体験を実現できないかと考え、2019年に音によるARプロジェクトをスタートさせました。

伊藤:昨今の世界は情報過多になってしまい、ユーザーにとって実生活と情報のバランスが悪くなってしまっていると思います。スマートフォンに目を奪われて、人と人との現実のコミュニケーションを阻害しているシーンもよく見かけます。しかし、サウンドを使うことで現実の世界にプライオリティを置きながら、情報をうまく差し込むことも可能であり、それこそが、我々が「Sound ARプロジェクト」を通して感じているオポチュニティです。

川上:私は音楽を外に持ち出すことで実世界を彩り、現実を拡張した最初のウェアラブルデバイスは「ウォークマン」だと思っています。今、現実を拡張する手段は、視覚を用いたものが主に取り沙汰されていますが、聴覚はデータ量も少なく、並行してさまざまな音の処理が可能であるなど、手軽に現実を拡張する手段として適しています。得られる情報量が多い視覚を「実世界」の方に向けて、「情報世界」上の情報は聴覚に委ねることで、偏ってしまったバランスをもう少し「実世界」に戻せるのではないか。つまり「スマートフォンから目を離して実世界をよく見てみよう」と。

伊藤:こうした耳・サウンドの分野での新たな可能性は、具体的な体験として表さないとなかなか伝わらないので、現在「Sound ARプロジェクト」でいろいろな仕掛けにトライしています。その一例が、「ムーミンバレーパーク」でのSound ARの実証実験です。

Sound ARによる新たなエンタテインメント体験

──Sound ARプロジェクトとはどのようなものでしょうか。

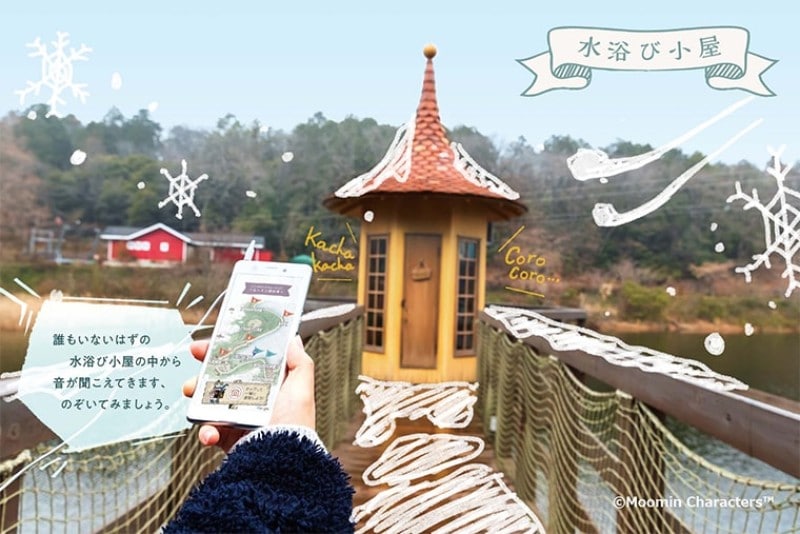

近藤:Sound ARは、「スマートフォンの画面からの解放」をコンセプトに、実世界の「音」と仮想世界の「音」を重ね、聴覚でのAR体験を提供するものです。このプロジェクトは、もともと社内のさまざまな部署で始まっていた、音のARに関する活動をひとつにまとめ、プロジェクト化されました。音のAR体験を実現するためには、技術とエンタテインメントの連携が不可欠であると考え、さまざまな分野からプロジェクトに参加してもらいソニーの強みを結集しました。この新しいサウンド体験とビジネス検証を目的に、2019年に埼玉県飯能市にオープンした「ムーミンバレーパーク」で『サウンドウォーク〜ムーミン谷の冬〜』というサウンドアトラクションを制作しました。

©Moomin Characters ™

八木:「ムーミンバレーパーク」は、自然の多いとても素晴らしいテーマパークなのですが、そこにキャラクターのセリフやBGM、環境音、ユーザーの動きに連動する効果音など、さまざまな音をレイヤー状に配置することで、場のエンタテインメント性をさらに向上できないかと考えました。このSound ARの実験で実世界に重ねたサウンドは、『ムーミン谷の冬』という原作の世界。ムーミンが冬眠から不意に目覚めてしまい、初めて見る雪の世界を冒険する物語です。ユーザーがオープンイヤーイヤホン STH40DとXperia™スマートフォンを身に着けてパーク内を散策すると、ザクッ、ザクッと、実世界にはない雪の上を歩いているようなサウンドがイヤホン越しに聞こえてきます。パーク内では個性豊かな仮想のキャラクターが近寄ってきたりして、ムーミンの世界へどんどん導いてくれます。位置や行動に連動した音声が再生され、あたかもムーミンの世界に入り込んで歩くような「サウンドのAR体験」ができます。Sound ARがあることで、パーク全体を舞台とした物語を再現し、これまでアトラクションではなかった場所をアトラクションとして成立させることができました。

Sound ARには、それを支える3つの特長があります。1つ目は、オープンイヤーイヤホンを採用し、周囲の音にイヤホンからの音を自然に重ねられること。2つ目は、ユーザーの位置や行動をリアルタイムにセンシングし、それに合った音声を再生するシステムです。このシステムは、ソニーホームエンタテインメント&サウンドプロダクツ(SHES)が独自に開発し、クリエイターがサウンドを配置できるクラウド上の仕組みを作り、ユーザーの位置測位や行動認識に基づいて音が自動再生され、実世界に重なるように工夫しました。3つ目は、立体的な音場を実現する空間音響技術です。これらのテクノロジーの組み合わせによって、より臨場感を高めた体験を作り上げました。

木下:パーク内を移動するユーザーに一貫したサウンド演出を提供し続けるため、SHESが注力したのは、精度よくユーザーの位置を把握し、豊富なサウンドコンテンツを安定して提供する技術の開発でした。サウンドコンテンツをマップ上に個別に配置できるようにし、リアルタイムで通信しながらアプリのGPS位置情報をもとにサウンドを再生する仕組みを構築。ここにR&Dセンターで開発した、センサーを用いて着地の瞬間に足音を再生する技術と体の向きに連動するオブジェクトベースの空間音響技術を実装することで多彩なシーンの演出を可能にしています。

実際には「ムーミンバレーパーク」に通い、GPS測位とLTE通信の状況を実測で何度も調べ、現状の測位技術で可能なサウンド配置方法やクラウドからの適切なデータ通信量を探りました。着地のセンシングでは首から下げたスマートフォンでも足の動きが精度よく検出できるように工夫を重ね、また空間音響ではその場での体験者の行動を想定したインタラクション設計を行うなど、キャラクターや風景の存在をリアルに感じられるまで調整を繰り返しました。

井手口:Sound ARのコンテンツ作りでは、プロジェクト立ち上げのときからソニー・ミュージックソリューションズ(SMS)として協創体制を構築してきました。この実証実験では、BGMや風の音だけでムーミンの気持ちの変化を表現するなど、音だけでストーリーや季節の移り変わりを伝えなければならなかったため、選曲・サウンドエフェクト制作には特にこだわりました。中でも、歩行時に雪を踏んだときの音が聴こえる“足音インタラクション”では、歩く動作に合わせたリアルタイムなインタラクションを実現するだけでなく、世界中の雪の足音を集めて、冬から春へと移り変わる雪の心地よい足音を追求しました。

布沢:ムーミンの世界観を音で表現するにあたり、R&Dセンターの技術と、ゲームサウンド制作で培ってきたノウハウ、アイデアも盛り込みました。例えば、ストーリーを伝える場面の多くに、これまで試行錯誤して作り上げた体験プロトタイプから得た「空間音響技術を活用する手法」を取り入れ、従来のステレオ再生では実現不可能であろう、あたかも劇場で聞いているかのようなサラウンドサウンド、臨場感、没入感を演出しました。一方、ユーザーにただ黙って聞いていてもらうだけでは体験として不十分です。ゲームの世界ではユーザーはコントローラーを操作することにより、リアルタイムかつインタラクティブな音のリアクションを得ることになりますが、サウンドウォークでは実世界のスマートフォンを介すことで、ユーザー自身がコントローラーになります。すなわち身体運動などのセンシング結果そのものが入力となり、身体という実世界と情報世界の音をつなげることで、まさに現実と仮想のシームレスに融合した音のAR体験を作り上げました。

身体的動作とリアルタイム・インタラクションの関係

──リアルタイム性と身体動作はどのような関係性なのでしょうか?

川上:私たちの身近にあるリアルタイム・インタラクションの例として、“建物とのインタラクション”もあるだろうと思っています。建物は、近づいてみるとより立体的に見えたり、裏側が見えたりと姿を変えますが、建築家は視点によって建築物の見え方を変えるところまで考え、人と建築とのインタラクションまで設計していると思っています。動かない建築物も、身体の動きと相互作用することで見え方を変える。人は常にさまざまな形でリアルタイム・インタラクションを行っているのです。

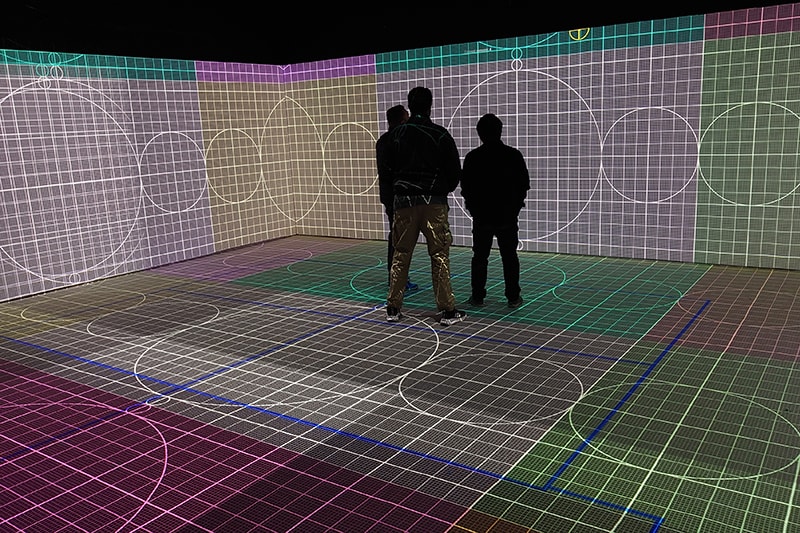

山本:建築物を見る向きを変えると建築物の形が変わるという現象を、現在のARやVRでも同じように体験できるようにしていますよね。情報世界が実世界を真似て、転写しているわけです。そこもリアルタイム性が重要になります。人の身体動作に対して違和感なく、実世界と同じような変化した分の情報が返ってくることがひとつのポイントになると考えています。

川上:サウンドウォークでの“足音インタラクション”もそうですが、ユーザーの位置情報と、見る向きを変えるなどの身体動作の情報を正確に取得し、それを違和感なくリアルタイムに反映しなくてはいけない。それは単純に文字を打ったり話したりして情報が返ってくる世界とは全く違いますね。

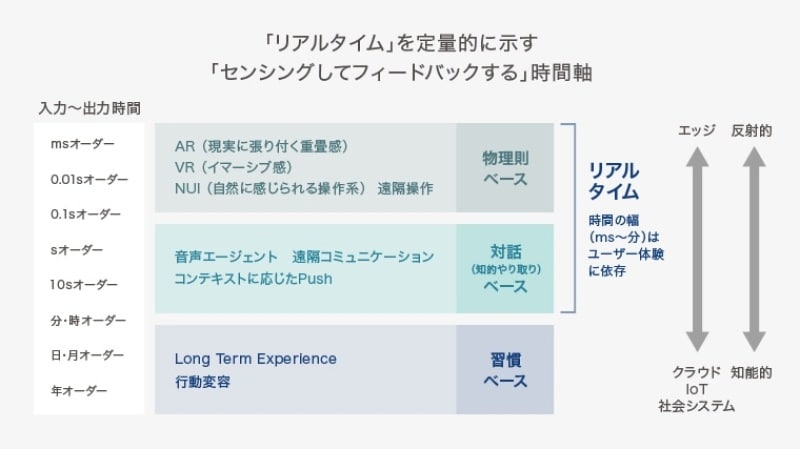

山本:ボタンを押して反応が戻ってくるまでには通常100〜300ミリ秒くらいありますが、それとはまるで違う速度のレイテンシー(遅延時間)が期待されているところですね。視覚や聴覚による差もありますし、用途によっても10倍くらい許容値が変わってきます。ある場所に入ると音楽や情報が返ってくる体験は、人の動きに合わせてザクッザクッという足音が耳に返ってくる体験と、同じリアルタイムでも期待されるレイテンシーが全然違います。おそらく単なる情報提供であれば10~20秒遅れてもそんなに分かりませんが、一方、足音の場合はアクションに対するフィードバックです。実世界で起きていることと同じ現象なので、実世界と同じくらいすぐにフィードバックが返ってこないと、すごく違和感があると思います。この2種類のフィードバックが混在している世界を両方とも実現する必要があると思っています。

川上:自分の動きに対する反応への遅れは気になりますよね。Sound ARはウェアラブルの領域なので、より身体についても考えないといけないと思います。

山本:音が遅れて聴こえてくるだけで、VR酔いのような現象が起こることもあります。実際に自分でも試してみましたが、わざと音を遅らせて自分の身体の反応とずれた状態にしたら、少し気分が悪くなってしまいました。

リアルタイム・インタラクションの未来

──今後どのようなアクションをとっていきたいと考えていますか?

伊藤:ここから10年間はクラウドとAIとデバイスの役割の再定義が進み、今当たり前と思われているインタラクションが大きく変わる可能性があると考えています。インタラクションが変わるとデバイスとクラウドやAIとの関係も変わりますし、コンテンツも変わっていく可能性があります。人とクラウドやAIが常につながっているような「常時接続化」や、操作レスでコンテンツにたどり着くような「自動化」がいろいろな領域で進むと考えています。私たちがフォーカスしている耳・サウンドに関しても、ずっと耳の周りに身に着けられる常時装着デバイスが登場し、好きな音楽やサウンドを探して耳に届けてくれるような自動コンテンツ提供サービスも出てくると思います。ソニーとしてこのサウンドのインタラクションが変わるタイミングを逃せないと考えています。そのためのさまざまな施策を打っていきたいですね。

川上:音は非常にバンド幅も狭いので、10年後まで考えても大きな仕掛けは不要で、端末もコストを抑えられるので広く普及するのではないでしょうか。さらには、デバイスがユーザーの代わりに届けるべき情報の取捨選択を行う形にも進化していくでしょう。個人のプライバシーを十分に担保しながら、インターネットからくるさまざまな情報を楽しめるという世の中になるといいなと思っています。

山本:明確な入力がないのに出力が分かるようなデバイスってまだ世の中にはありません。私たちは今、21世紀のマウスを発明しているところだと思っています。今のマウスは、ただ座標の変化量を出すだけのデバイスですが、UIの中でのすさまじい影響力を持っています。私たちはそれに近いことに取り組んでいると捉えています。歩いたりジャンプしたりという行動をセンシングし、人は情報に対して無意識なのに確実に必要な情報をフィードバックするような世界。そこに楔を打つ新しい取り組みをやっているという意識です。未来のマウスであれば、一斉に100万人が入力することもあるかもしれません。UIの構造が今とは変わると思うので、未来を見据えてアーキテクチャを構築する必要もあります。IoTやAIのメガトレンドの中で絶対に必要なピースになると思いますので、実現することができれば10~20年単位でソニーが市場をリードすることにもつながるのかなと考えています。

伊藤:マウスの話は私も同意です。ソニーは、マウスやスマートフォンのタッチインタラクションなど、インタラクションの革新を起こせる可能性のあるタイミングで一番手になる機会を逃してきたのではないかと思っています。いま私たちは耳・サウンドにフォーカスしていますが、同時にいろいろなエリアでインタラクションの革新が起こってくると思いますので、イノベーションが好きな仲間とこの波を逃さないよう活動していきたいと思います。

川上:音は優れたメディアなのに未だにテクノロジーを生かしたインタラクションに汲み上げられてないのではないでしょうか。音を使って、イメージを含めたVR方面と同じことをするだけですごく面白いことができるはずが、業界の中でもしっかり深掘りされていない気がしています。だからこそ、ソニーのようなサウンドで高い技術力を持つ会社がやるといいのではないかと。10年後に向けてしっかりやっていきたいと考えています。